? 优质资源分享 ?

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| ? Python实战微信订餐小程序 ? | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |

| ?Python量化交易实战? | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

论文信息

论文标题:Deep Graph Clustering via Dual Correlation Reduction论文作者:Yue Liu, Wenxuan Tu, Sihang Zhou, Xinwang Liu, Linxuan Song, Xihong Yang, En Zhu论文来源:2022, AAAI论文地址:download 论文代码:download

1 介绍

表示崩塌问题:倾向于将所有数据映射到相同表示。

创新点:提出使用表示相关性来解决表示坍塌的问题。

2 方法

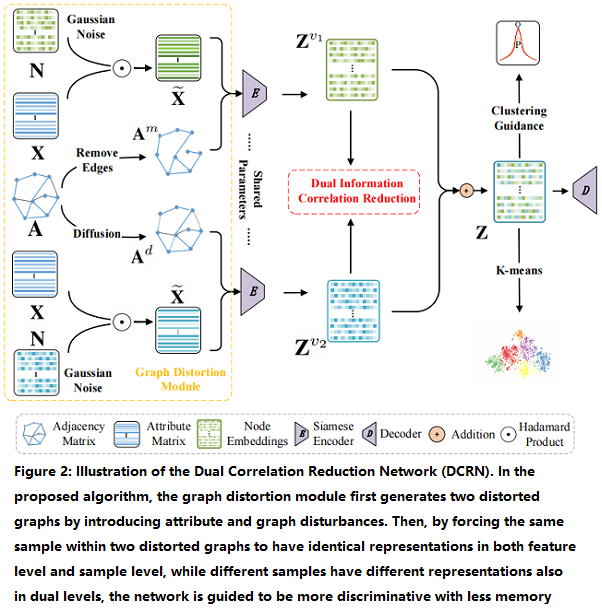

2.1 整体框架

该框架包括两个模块:

-

- a graph distortion module;

- a dual information correlation reduction (DICR) module;

2.2 相关定义

A˜=D−1(A+I)andA˜∈RN×NA~=D−1(A+I)andA~∈RN×N\widetilde{\mathbf{A}}=\mathbf{D}^{-1}(\mathbf{A}+\mathbf{I})\quad\quad \text{and} \quad\quad \widetilde{\mathbf{A}} \in \mathbb{R}^{N \times N}

2.3 Graph Distortion Module

Feature Corruption:

首先从高斯分布矩阵 N(1,0.1)N(1,0.1) \mathcal{N}(1,0.1) 采样一个随机噪声矩阵 N∈RN×DN∈RN×D\mathbf{N} \in \mathbb{R}^{N \times D} ,然后得到破坏后的属性矩阵 X˜∈RN×DX~∈RN×D\widetilde{\mathbf{X}} \in \mathbb{R}^{N \times D} :

X˜=X⊙N(1)X~=X⊙N(1)\widetilde{\mathbf{X}}=\mathbf{X} \odot \mathbf{N} \quad\quad\quad(1)

Edge Perturbation:

- similarity-based edge removing

根据表示的余弦相似性先计算一个相似性矩阵,然后根据相似性矩阵种的值小于 0.10.10.1 将其置 000 来构造掩码矩阵(masked matrix)M∈RN×NM∈RN×N\mathbf{M} \in \mathbb{R}^{N \times N}。对采用掩码矩阵处理的邻接矩阵做标准化:

Am=D−12((A⊙M)+I)D−12(2)Am=D−12((A⊙M)+I)D−12(2)\mathbf{A}^{m}=\mathbf{D}^{-\frac{1}{2}}((\mathbf{A} \odot \mathbf{M})+\mathbf{I}) \mathbf{D}^{-\frac{1}{2}}\quad\quad\quad(2)

- graph diffusion

Ad=α(I−(1−α)(D−12(A+I)D−12))−1(3)Ad=α(I−(1−α)(D−12(A+I)D−12))−1(3)\mathbf{A}^{d}=\alpha\left(\mathbf{I}-(1-\alpha)\left(\mathbf{D}^{-\frac{1}{2}}(\mathbf{A}+\mathbf{I}) \mathbf{D}^{-\frac{1}{2}}\right)\right)^{-1}\quad\quad\quad(3)

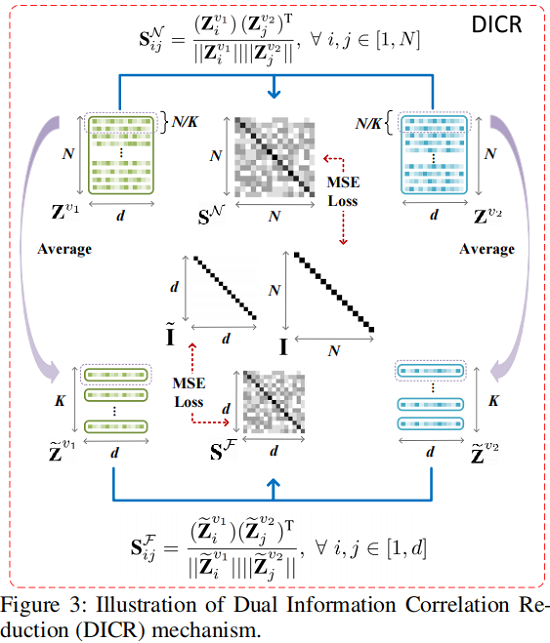

2.4 Dual Information Correlation Reduction

框架如下:

Sample-level Correlation Reduction

对于由 siamese graph encoder 学习到的双视图节点嵌入 Zv1Zv1 \mathbf{Z}^{v_{1}} 和 Zv2Zv2\mathbf{Z}^{v_{2}} ,我们首先通过以下方法计算交叉视图样本相关性矩阵SN∈RN×NSN∈RN×N\mathbf{S}^{\mathcal{N}} \in \mathbb{R}^{N \times N} :

SNij=(Zv1i)(Zv2j)T∥∥Zv1i∥∥∥∥Zv2j∥∥,∀i,j∈1,NSijN=(Ziv1)(Zjv2)T‖Ziv1‖‖Zjv2‖,∀i,j∈1,N{\large \mathbf{S}_{i j}^{\mathcal{N}}=\frac{\left(\mathbf{Z}_{i}^{v_{1}}\right)\left(\mathbf{Z}_{j}^{v_{2}}\right)^{\mathrm{T}}}{\left|\mathbf{Z}_{i}^{v_{1}}\right|\left|\mathbf{Z}_{j}^{v_{2}}\right|}} , \forall i, j \in[1, N]\quad\quad\quad(4)

其中:SNij∈[−1,1]SijN∈[−1,1]\mathbf{S}_{i j}^{\mathcal{N}} \in[-1,1] 表示第一个视图中第 iii 个节点嵌入与第二个视图中第 jjj 个节点嵌入的余弦相似度。

然后利用 SNSN\mathbf{S}^{\mathcal{N}} 计算:

LN=1N2∑N(SN−I)2=1N∑i=1N(SNii−1)2+1N2−N∑i=1N∑j≠i(SNij)2(5)LN=1N2∑N(SN−I)2=1N∑i=1N(SiiN−1)2+1N2−N∑i=1N∑j≠i(SijN)2(5)\begin{aligned}\mathcal{L}_{N} &=\frac{1}{N^{2}} \sum\limits^{N}\left(\mathbf{S}^{\mathcal{N}}-\mathbf{I}\right)^{2} \&=\frac{1}{N} \sum\limits_{i=1}^{N}\left(\mathbf{S}_{i i}^{\mathcal{N}}-1\right)^{2}+\frac{1}{N^{2}-N} \sum\limits_{i=1}^{N} \sum\limits_{j \neq i}\left(\mathbf{S}_{i j}^{\mathcal{N}}\right)^{2}\end{aligned}\quad\quad\quad(5)

LNLN\mathcal{L}_{N} 的第一项鼓励 SNSN\mathbf{S}^{\mathcal{N}} 中的对角线元素等于 111,这表明希望两个视图的节点表示一致性高。第二项使 SNSN\mathbf{S}^{\mathcal{N}} 中的非对角线元素等于 000,以最小化在两个视图中不同节点的嵌入之间的一致性。

Feature-level Correlation Reduction

首先,我们使用读出函数 R(⋅):Rd×N→Rd×KR(⋅):Rd×N→Rd×K\mathcal{R}(\cdot): \mathbb{R}^{d \times N} \rightarrow \mathbb{R}^{d \times K} 将双视图节点嵌入 Zv1Zv1\mathbf{Z}^{v_{1}} 和 Zv2Zv2\mathbf{Z}^{v_{2}} 分别投影到 Z˜v1Z~v1\widetilde{\mathbf{Z}}^{v_{1}} 和 Z˜v2∈Rd×KZ~v2∈Rd×K\widetilde{\mathbf{Z}}^{v_{2}} \in \mathbb{R}^{d \times K} 中,该过程公式化为:

Z˜vk=R((Zvk)T)(6)Z~vk=R((Zvk)T)(6)\widetilde{\mathbf{Z}}^{v_{k}}=\mathcal{R}\left(\left(\mathbf{Z}^{v_{k}}\right)^{\mathrm{T}}\right)\quad\quad\quad(6)

同样此时计算 Z˜v1Z~v1\widetilde{\mathbf{Z}}^{v_{1}} 和 Z˜v2Z~v2\widetilde{\mathbf{Z}}^{v_{2}} 之间的相似性:

SFij=(Z˜v1i)(Z˜v2j)T∥∥Z˜v1i∥∥∥∥Z˜v2j∥∥,∀i,j∈1,dSijF=(Z~iv1)(Z~jv2)T‖Z~iv1‖‖Z~jv2‖,∀i,j∈1,d{\large \mathbf{S}_{i j}^{\mathcal{F}}=\frac{\left(\widetilde{\mathbf{Z}}_{i}^{v_{1}}\right)\left(\widetilde{\mathbf{Z}}_{j}^{v_{2}}\right)^{\mathrm{T}}}{\left|\widetilde{\mathbf{Z}}_{i}^{v_{1}}\right|\left|\widetilde{\mathbf{Z}}_{j}^{v_{2}}\right|}} , \forall i, j \in[1, d]\quad\quad\quad(7)

然后利用 SFSF\mathbf{S}^{\mathcal{F}} 计算:

LF=1d2∑S(SF−I˜)2=1d2∑i=1d(SFii−1)2+1d2−d∑i=1d∑j≠i(SFij)2(8)LF=1d2∑S(SF−I~)2=1d2∑i=1d(SiiF−1)2+1d2−d∑i=1d∑j≠i(SijF)2(8)\begin{aligned}\mathcal{L}_{F} &=\frac{1}{d^{2}} \sum\limits^{\mathcal{S}}\left(\mathbf{S}^{\mathcal{F}}-\widetilde{\mathbf{I}}\right)^{2} \&=\frac{1}{d^{2}} \sum\limits_{i=1}^{d}\left(\mathbf{S}_{i i}^{\mathcal{F}}-1\right)^{2}+\frac{1}{d^{2}-d} \sum\limits_{i=1}^{d} \sum\limits_{j \neq i}\left(\mathbf{S}_{i j}^{\mathcal{F}}\right)^{2}\end{aligned}\quad\quad\quad(8)

下一步将两个视图的表示合并得:

Z=12(Zv1+Zv2)(9)Z=12(Zv1+Zv2)(9)\mathbf{Z}=\frac{1}{2}\left(\mathbf{Z}^{v_{1}}+\mathbf{Z}^{v_{2}}\right)\quad\quad\quad(9)

上述所提出的 DICR 机制从样本视角和特征水平的角度都考虑了相关性的降低。这样,可以过滤冗余特征,在潜在空间中保留更明显的特征,从而学习有意义的表示,避免崩溃,提高聚类性能。

Propagated Regularization

为了缓解网络训练过程中出现的过平滑现象,我们引入了一种传播正则化方法,即:

LR=JSD(Z,A~Z)(10)LR=JSD(Z,A~Z)(10)\mathcal{L}_{R}=J S D(\mathbf{Z}, \tilde{\mathbf{A}} \mathbf{Z})\quad\quad\quad(10)

综上 DICR ,模块的目标函数为:

LDICR=LN+LF+γLR(11)LDICR=LN+LF+γLR(11)\mathcal{L}_{D I C R}=\mathcal{L}_{N}+\mathcal{L}_{F}+\gamma \mathcal{L}_{R}\quad\quad\quad(11)

2.5 目标函数

总损失函数如下:

L=LDICR+LREC+λLKL(12)L=LDICR+LREC+λLKL(12)\mathcal{L}=\mathcal{L}_{D I C R}+\mathcal{L}_{R E C}+\lambda \mathcal{L}_{K L}\quad\quad\quad(12)

分别代表着 DICR的损失LDICRLDICR\mathcal{L}_{D I C R}、重建损失LRECLREC\mathcal{L}_{R E C} 和聚类损失 LKLLKL \mathcal{L}_{K L}。

后面两个损失参考 DFCN。

【我本文认为它这个相关性的方法存在不合理之处,没考虑邻居节点,本文之所以有效,也许可能正是它后面加了一个自表达模型】

3 实验

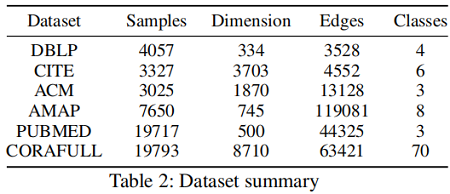

数据集:

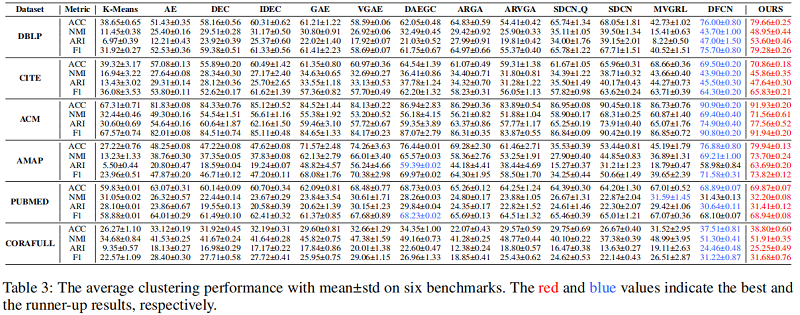

基线实验:

4 结论

在这项工作中,我们提出了一种新的自监督深度图聚类网络,称为双相关减少网络(DCRN)。在我们的模型中,引入了一种精心设计的双信息相关减少机制来降低样本和特征水平上的信息相关性。利用这种机制,可以过滤掉两个视图中潜在变量的冗余信息,可以很好地保留两个视图的更鉴别特征。它在避免表示崩溃以实现更好的聚类方面起着重要的作用。在6个基准测试上的实验结果证明了DCRN的优越性。

-

- 1 介绍

- 2 方法

- 2.1 整体框架

- 2.2 相关定义

- 2.3 Graph Distortion Module

- 2.4 Dual Information Correlation Reduction

- 2.5 目标函数

- 3 实验

- 4 结论

__EOF__

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-hvxXzBpi-1650474774487)(https://blog.csdn.net/BlairGrowing)]Blair - 本文链接: https://blog.csdn.net/BlairGrowing/p/16171545.html

转载请注明:xuhss » 论文解读(DCRN)《Deep Graph Clustering via Dual Correlation Reduction》