文章目录

显示

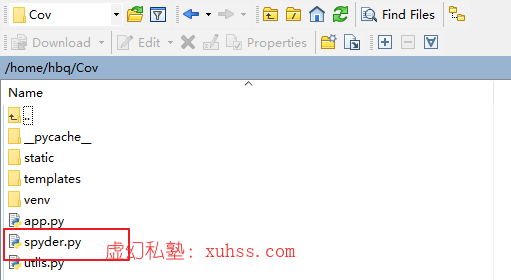

一、创建一个spyder.py文件

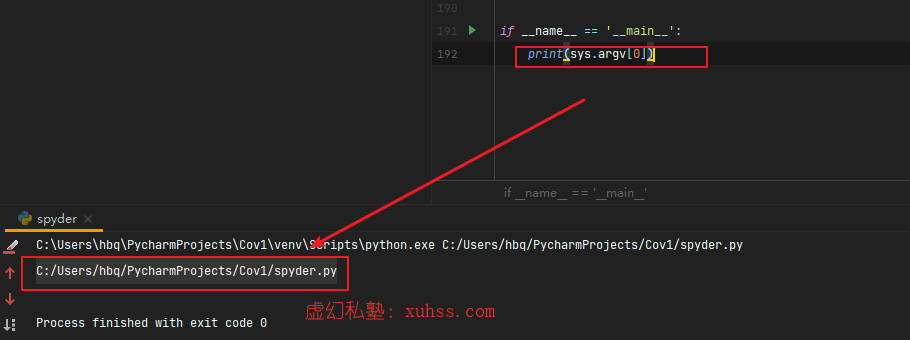

通过代码测试参数的传递

二、根据不同参数调用不同方法

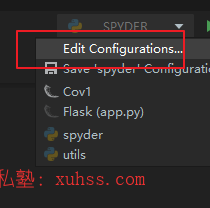

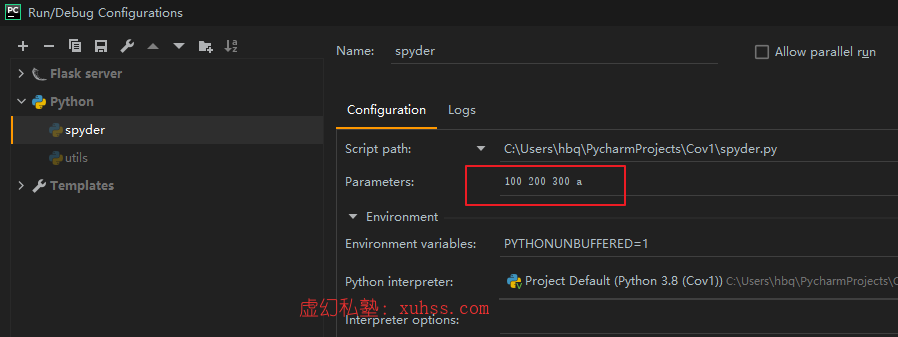

Pycharm传递参数:

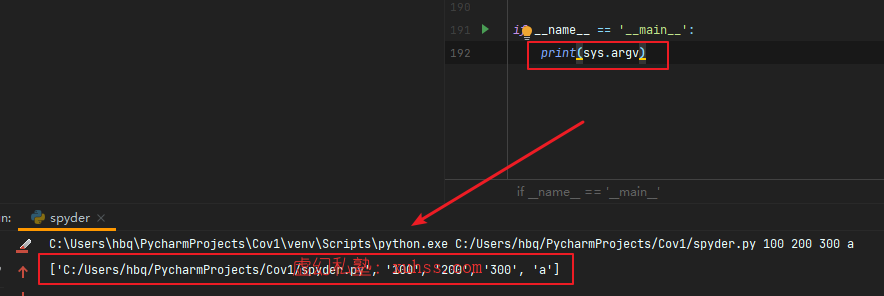

运行脚本获取到被传递的参数:

所以可以根据参数的值,来执行不同的操作:

if __name__ == '__main__':

l = len(sys.argv)

if l == 1:

s = """

请输入参数

参数说明:

up_his 历史记录表

up_hot 百度热搜

up_det 每日详细表

"""

print(s)

else:

order = sys.argv[1]

if order == "up_his":

update_history()

elif order == "up_det":

update_details()

elif order == "up_hot":

update_hotsearch()三、部署定时爬虫

1.上传脚本:

2.服务器上安装selenium

pip3 install requests

pip3 install selenium3.Linux安装chrome

3.1 cenos 安装

sudo su root

yum install https://dl.google.com/linux/direct/google-chrome-stable_current_x86_64.rpm3.2 Ubuntu安装

一、选择安装位置

sudo mkdir /download_packages

cd /download_packages二、下载

Chrome32位版本:

wget https://dl.google.com/linux/direct/google-chrome-stable_current_i386.debChrome64位版本:

wget https://dl.google.com/linux/direct/google-chrome-stable_current_amd64.deb三、安装chrome

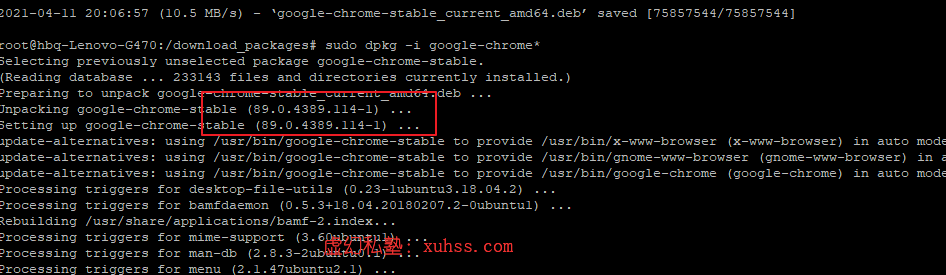

sudo dpkg -i google-chrome*

sudo apt-get -f install安装过程中可以知道版本

4.下载chromedriver

http://npm.taobao.org/mirrors/chromedriver/4.1下载对应版本

wget -N http://http://npm.taobao.org/mirrors/chromedriver/89.0.4389.23/chromedriver_linux64.zip4.2解压并赋予权限

unzip chromedriver_linux64.zip

chmod +x chromedriver4.3添加软链接

ln -s /usr/local/share/chromedriver /usr/local/bin/chromedriver

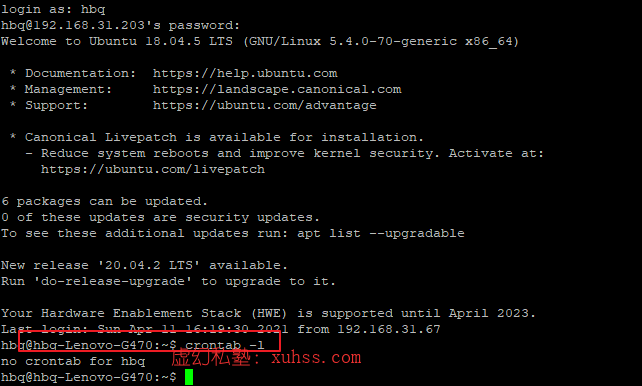

ln -s /usr/local/share/chromedriver /usr/bin/chromedriver5.获取crontab

5.1 crontab -l 列出当前任务

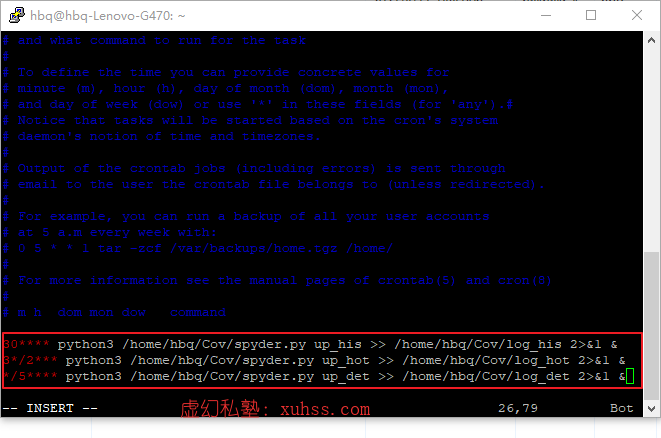

5.2 crontab -e 编辑任务

格式:

***** 指令

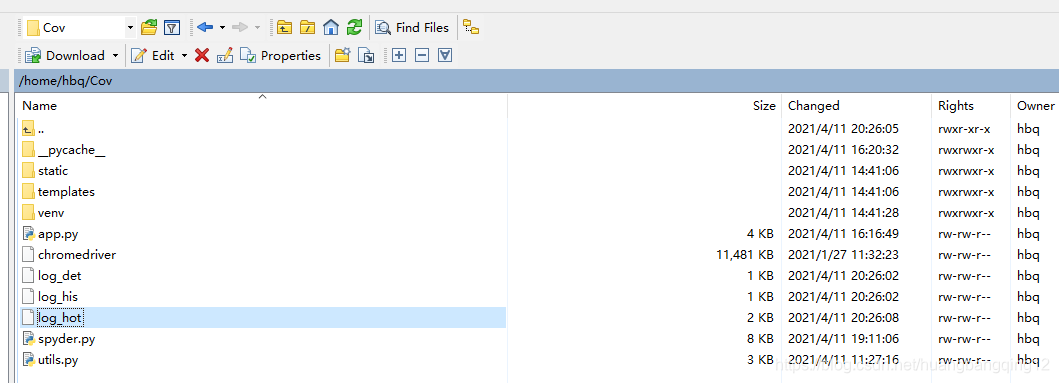

5个星号分别代表 分、时、日、月、周30 * * * * python3 /home/hbq/Cov/spyder.py up_his >> /home/hbq/Cov/log_his 2>&1 &

3 */2 * * * python3 /home/hbq/Cov/spyder.py up_hot >> /home/hbq/Cov/log_hot 2>&1 &

*/5 * * * * python3 /home/hbq/Cov/spyder.py up_det >> /home/hbq/Cov/log_det 2>&1 &最后 可以看到抓取到的文件的log信息:

在这里插入图片描述

转载请注明:xuhss » Python Flask定时调度疫情大数据爬取全栈项目实战使用-20Linux下部署定时爬虫